- 相关博文

- 最新资讯

-

消息队列技术选型分析:RabbitMQ、RocketMQ与Kafka对比 本文从实战角度对三大主流消息队列进行多维度对比分析。RabbitMQ基于AMQP协议,提供灵活路由和图形化管理,适合中小型系统;RocketMQ由阿里开发,具备金融级高可靠性和高吞吐特性;Kafka则专为高吞吐流处理设计,与大数据生态深度集成。三者各具特色:RabbitMQ路由灵活但吞吐有限,RocketMQ在事务消息和顺序消息方面表现优异,Kafka则在大规模数据处理上优势明显。文章通过架构图、性能指标表和典型场景分析,为开发者提供

-

从 256 天的创作节点回望这段旅程,这不仅是一份个人成长的记录,更是技术、坚持与热爱的交汇。从竞赛与认证的打磨,到近百万访问量的积累,再到对未来的清晰规划,这篇文字讲述了我在 CSDN 持续输出、以写促学、与技术同行的真实心路。

-

本文介绍了RabbitMQ集群的搭建与使用,重点阐述了仲裁队列和负载均衡的实现方法。针对单机版RabbitMQ的局限性,文章详细讲解了如何通过集群实现高可用和线性扩展,特别强调了3.8版本引入的仲裁队列机制,它基于Raft协议确保数据安全性和一致性。文章还演示了节点故障时的数据同步过程,并介绍了使用HAProxy实现负载均衡的方案,确保在节点宕机时服务不中断。通过实际配置和测试案例,展示了RabbitMQ集群在生产环境中的可靠性保障和性能优化方案。

-

/ 1. 复用Reducer作为Combiner(局部聚合,减少Shuffle数据量)// 2. 自定义Partition:按单词首字母分区,均衡Reduce负载@Override// 按单词首字母哈希值分区// 驱动类中配置自定义Partition// 设置Reduce任务数量(与分区数对应)如果说知识与技能是Hadoop课程的“显性收获”,那么善于思考、善于总结的学习习惯,则是这门课程带给我的“隐性财富”,也是编程类、软件工程类课程学习的核心要义。

-

本文深度横评北大法宝、Wind、同花顺及新兴工具“策知道”等产品,从效果、费用、功能侧重等方面对于查政策场景进行比较。

-

Git分支合并指南摘要 本文详细介绍了将特定提交从一个Git分支合并到另一个分支的多种方法。主要内容包括: 核心方法: cherry-pick:最常用方式,可合并单个或多个提交 merge --no-ff:通过临时分支合并部分功能 补丁应用:使用format-patch和apply 操作场景: 合并连续/不连续的提交 处理远程分支提交 选择性合并文件或目录 修改提交信息 冲突解决: 使用--continue、--skip或--abort 配置合并工具(vimdiff/vscode等) 最佳实践: 先拉取最新

-

本文详细分析了 Elasticsearch 中三种关键查询参数的区别与联系。terminate_after:真正的 LIMIT 机制,达到指定数量立即停止扫描,显著提升查询速度但可能返回不足量结果。track_total_hits:仅限制精确计数值,不影响结果返回,适合大数据集近似统计。size:传统分页参数,需要完整扫描和排序,内存消耗大。通过工作流程代码示例、实际行为对比和 SQL 类比,文章揭示了各参数的本质差异,并提供了场景测试数据和应用建议。

-

本文介绍了 Elasticsearch 查询性能调优的关键参数和方法。主要包括三个核心保护参数:timeout 设置查询超时时间,terminate_after 限制最大返回文档数,track_total_hits 控制命中数计算。同时分析了 composite 聚合的分页机制及其内存优势。通过流程图展示了完整查询流程,并比较了有无保护参数的实际执行差异。最后提出了分层查询策略等优化建议,帮助开发者平衡查询深度与系统负载。这些措施能有效防止复杂查询耗尽资源,保障集群稳定性。

-

本研究系统梳理了大数据在金融风险管理中的应用现状,明确了大数据技术对风险监测、风险评估和风险控制等方面的积极作用。通过对国内外文献的综述和案例分析,揭示了大数据在金融风险管理中面临的挑战,包括数据质量、数据安全、算法偏差、技术瓶颈以及监管与合规等方面。针对上述挑战,本文提出了相应的策略和建议,包括提高数据质量、加强数据安全、校正算法偏差、技术创新与突破以及监管与合规建议,旨在为金融机构有效应用大数据进行风险管理提供理论支持和实践参考。研究总结要点内容应用现状。

-

本文介绍了一个基于SpringBoot和Hadoop的现代化图书管理系统。系统采用前后端分离架构,包含用户权限管理、图书管理、借阅管理、数据可视化等核心功能模块,并集成了Hadoop大数据处理能力。系统架构清晰,包含前端界面、SpringBoot控制器层、MySQL数据库、服务层和Hadoop集群。项目结构规范,分为控制器层、服务层、数据访问层、实体类等多个模块,支持RBAC权限控制、Excel批量操作、库存自动更新等功能,适合中小型图书馆使用。

-

第一次在gitee上看我图文教程的强烈建议点击这个按钮。

-

ELK企业日志分析系统摘要 ELK是一套开源实时日志分析平台,由Elasticsearch、Logstash和Kibana三大核心组件构成,提供从日志收集、处理、存储到可视化的完整解决方案。系统采用分布式架构,支持PB级数据存储和毫秒级检索,通过倒排索引技术实现高效查询。Logstash负责多源日志收集和预处理,Elasticsearch提供分布式存储和索引,Kibana实现可视化展示。典型部署包含主从节点集群,配置需注意跨域访问、数据目录权限等关键设置。系统广泛应用于日志分析、性能监控和安全事件管理等领域

-

本文介绍了Spark SQL中的多个数学和加密函数,包括: 基础数学函数:abs(绝对值)、acos(反余弦)、acosh(反双曲余弦) 日期函数:add_months(添加月份) 高级加密函数:aes_decrypt(AES解密)和aes_encrypt(AES加密),支持多种加密模式和填充方式 这些函数从Spark 1.2.0到3.3.0的不同版本开始引入,提供了数值计算、日期处理和加密解密功能,示例代码展示了各函数的具体用法。

-

本文摘要:该文档详细记录了大数据环境配置流程,包括用户登录、工具安装(nano/unzip)、环境变量配置(sbt/kafka)、文件解压部署(Hadoop/HBase/Spark)、权限修改、Hadoop免密登录设置(SSH密钥生成)、以及三大组件启动流程(HDFS格式化、start-all.sh启动Hadoop、spark-shell验证、HBase启动)。关键步骤涉及系统路径修改(/etc/profile)、目录所有权变更(chown)和SSH认证配置,为后续大数据实验搭建了完整的基础运行环境。

-

一、MapReduce 概述:分布式计算的核心引擎在大数据时代,面对 TB 级甚至 PB 级的海量数据,传统的单机计算模式早已力不从心。分布式计算框架应运而生,成为处理海量数据的关键技术支撑。MapReduce 作为 Hadoop 生态系统的核心组件之一,是一种面向大规模数据集的分布式并行计算模型,其设计理念源于 “分而治之” 的经典思想,专为离线数据处理场景量身打造。MapReduce 的核心价值在于将复杂的大规模计算任务拆解为多个可并行执行的子任务,在分布式集群的多个节点上同时处理,最后将所有子任务

-

《电子文件管理100问》与云深文档管理系统共同构建了数字化时代的文件管理新范式。前者作为权威理论指南,系统解答了电子文件全生命周期管理的核心问题;后者则将这些理论转化为智能实践,通过数字存证、四性检测、格式转换等技术手段,实现真实性保障和长期可读性。系统还创新性地运用AI分类、自然语言检索和精细权限管控,解决了高效检索与安全共享的平衡难题。二者的结合推动文档管理从被动存储转向主动治理,从成本中心升级为价值创造中心,为组织数字化转型提供了理论指导与技术支撑的完整解决方案。

-

摘要:本文介绍了Spark SQL中的多种schema解析函数,包括schema_of_avro、schema_of_csv、schema_of_json、schema_of_variant、schema_of_variant_agg和schema_of_xml,用于从不同格式数据中提取结构定义。同时还介绍了数学函数sec、时间函数second、文本处理函数sentences以及序列生成函数sequence。这些函数支持从Spark 1.5到4.0的不同版本,提供了处理结构化数据的便捷方法。

-

本文介绍了Apache Spark SQL中常用的日期处理函数,包括date()、date_add()、date_diff()、date_format()等。这些函数可用于日期转换、日期加减、日期差计算、日期格式化等操作。每个函数都提供了语法说明、参数解释和使用示例,如date_add()计算指定天数后的日期,date_diff()计算两个日期之间的天数差。文章还包含了函数的版本信息(Since字段),帮助开发者了解函数兼容性。这些日期函数为Spark SQL中的时间数据处理提供了强大支持。

-

本文详细介绍了使用LocalAI部署Qwen3-32B大模型并构建RAG应用的完整流程。主要内容包括:1) 安装Elasticsearch和Kibana 9.0.1;2) 配置加密密钥和白金版试用功能;3) 部署Elasticsearch自带的.multilingual-e5-small向量模型;4) 通过Docker或brew安装LocalAI服务;5) 下载并验证Qwen3-32B模型;6) 创建Elasticsearch连接器。特别指出在macOS M3 Pro上使用Metal加速后,推理速度从0.1

-

看完这一篇,你就对 Spring Security 略窥门径了

开发Web应用,对页面的安全控制通常是必须的。比如:对于没有访问权限的用户需要转到登录表单页面。要实现访问控制的方法多种多样,可以通过Aop、拦截器实现,也可以通过框架实现,例如:Apache Shiro、Spring Security。我们这里要讲的Spring Security 就是一个Spring生态中关于安全方面的框架。它能够为基于Spring的企业应用系统提供声明式的安全访问控制解决方案。

-

为什么要在油气行业中应用 IoT?这 8 个应用场景告诉你 IoT 在油气行业中可以做什么...

如今,物联网已经进入了各行各业:汽车、农业、绿色能源。物联网还将征服的领域之一是石油和天然气领域。在这些特殊的行业环境中,公司雇佣专业人员来预测机器何时需要维护和保养。通过物联网监控,以确保员工在工作环境中的安全,并改善生产。 麦肯锡 (McKinsey Global Institute)研究表明,到2025年,物联网有可能吸引$11.1T 的资金。

-

ES2020 是 ECMAScript 对应 2020 年的版本。这个版本不像 ES6 (ES2015)那样包含大量新特性。但也添加了许多有趣且有用的特性。本文的代码地址:https://github.com/ljianshu/Blog 本文以简单的代码示例来介绍 ES2020新特性。这样,你可以很快理解这些新功能,而不需要多么复杂的解释。

-

在本文中,我们将开始开发自己的Kubernetes控制器。 技术栈可以是Python、NodeJS或Ruby。因为这个博客被命名为为“ Java极客”,因此选择Java是很正常的。 作为一个用例,我们将实现sidecar模式:每当一个pod被调度时,sidecar pod也会随之被调度。如果将前者删除,则后者也必须删除。

-

其实“数据湖”的概念由来已久,如果追溯时间大概可以到2011年。如今我们经常提及的数据湖其实可以被认为是一个集中式的安全存储库,用户可以任何规模存储、管理、发现并共享所有结构化和非结构化数据,过程中无需预定义架构。

-

医疗保健、零售、金融、制造业……一文带你看懂大数据对工业领域的影响!...

随着大数据技术的兴起,工业领域在很大程度上发生了变化。智能手机和其他通讯方式的使用迅速增加,使得每天都能收集大量数据。以下是大数据对工业领域的影响。

-

2020年已经到来,它的到来带来了信息和技术(IT)领域的诸多创新和变革,特别是对DevOps技术的创新和变革。美国领先的调查机构Grand View Research的专家进行的一项研究宣称,预计到2025年,DevOps的市场价值将达到128.5亿美元。

-

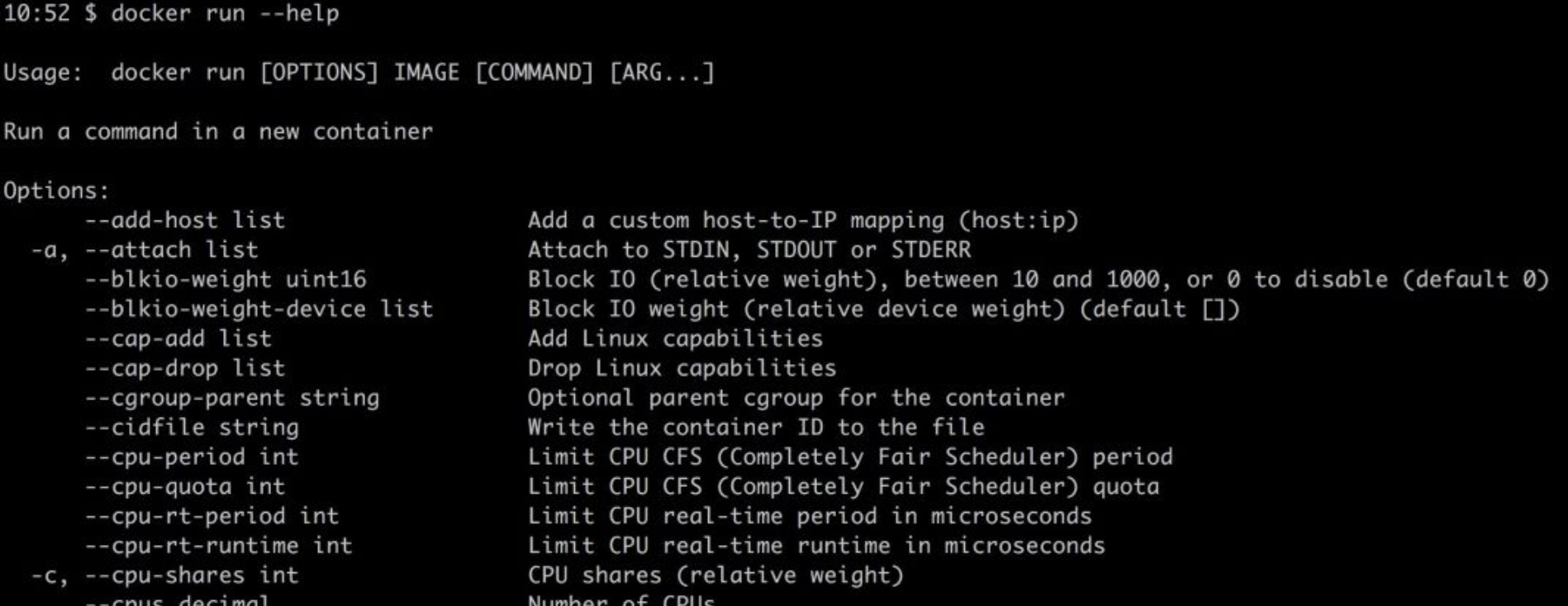

Docker容器已经从一种锦上添花的技术转变成了部署环境的必需品。有时,作为开发人员,我们需要花费大量时间调试或研究Docker工具来帮助我们提高生产力。每一次新技术浪潮来临之际,我们都需要花费大量时间学习。

-

SQL是用于数据分析和数据处理的最重要的编程语言之一,因此SQL问题始终是与数据科学相关工作(例如数据分析师、数据科学家和数据工程师)面试过程中的一部分。 SQL面试旨在评估应聘者的技术和解决问题的能力。因此,至关重要的是,不仅要根据样本数据编写正确的查询语句,而且还要像对待现实数据集一样考虑各种情况和极端情况。

-

近日,阿里云对外宣布其容器服务调度GPU云服务器启动加速计算,最快只需60秒即可完成新冠病毒的核酸对比工作;同时将向医疗科研机构、疾控中心等一线病毒研究机构免费开放基因计算服务,技术可大幅提升宏基因组测序、疫苗研发相关的处理效率。基于此,晶少专程采访了阿里云基因计算服务AGS负责人、高级技术专家李鹏,集中呈现针对GPU和容器技术大幅提升核酸比对速度的有关细节以及关于阿里云基因计算服务(AGS)的诸多信息。

-

最近,我构建了一个本地开发环境,该环境使用 Docker 进行一些关键的集成测试。 在我要完成这项工作时,我意识到在开始这项工作之前,我没有考虑到这么做的一些意义深远影响,如:

-

数据库连接池和线程池等池技术存在的意义都是为了解决资源的重复利用问题。在计算机里,创建一个新的资源往往开销是非常大的。而池技术可以统一分配,管理某一类资源,它允许我们的程序可以重复的使用这个资源,只有在极端情况下(比如连接池满)才会创建新的资源。

-

从提取层、处理层、基础结构入手,带你了解Spark和Kafka!

电子商务市场中典型的一天是这样的:每分钟发生1万个事件流,并且要选择合适的工具对其进行处理。

-

随着业务的发展,MySQL数据库中的表会越来越多,表中的数据量也会越来越大,相应地,数据操作的开销也会越来越大;另外,无论怎样升级硬件资源,单台服务器的资源(CPU、磁盘、内存、网络IO、事务数、连接数)总是有限的,最终数据库所能承载的数据量、数据处理能力都将遭遇瓶颈。

-

王坚博士曾经做过这样一个非常形象的比喻,他将做 App 比作是在别人的花园里弄盆栽,「种点花草是没有问题的」,不过「别人叫你的产品下架你就得下架,这是有问题的」,现在在 GitHub 上,众多的开发者显然遭遇了这样的问题。