- 相关博文

- 最新资讯

-

输出会包含分区数、副本数、ISR(同步副本)、leader 分区等关键信息。命令行,生产者和消费者当然也是可以通过命令行操作的,但是这样真的有意义吗?(默认开启),否则仅标记为删除,不会实际删除。

-

场景Consul+任意RPC注册中心刚宕机(缓存未过期)100%成功100%成功100%成功100%成功100%成功宕机30分钟+(缓存失效,服务无变动)95%+成功(少量警告)95%+成功(少量警告)95%+成功(少量警告)90%+成功(无文件缓存)98%+成功(健康检查筛选)宕机30分钟+(缓存失效,服务有变动)部分失败(10%-20%)部分失败(10%-20%)部分失败(10%-20%)部分失败(30%-50%)少量失败(5%-10%)

-

对于甲方安全新人而言,入门最易陷入的误区,是一上来就钻研漏洞挖掘、工具使用,却忽略了甲方安全的核心逻辑——所有安全防护都必须贴合业务、围绕资产展开。脱离业务的安全是“空中楼阁”,遗漏资产的防护则是“纸上谈兵”。与其急于上手复杂工具,不如先沉下心,把业务梳理清楚、把资产盘点明白,这才是甲方安全工作的根基,也是新人快速立足的关键。本文将从业务梳理、资产盘点、动态更新、实战示例四个维度,给甲方安全新人一套可直接落地的入门方案,避开“盲目跟风学工具”的坑,从源头搭建甲方安全的认知框架。

-

HIVE数仓常用ETL加载算法实现,实际开发中常用

-

本文介绍了Git工具的安装配置及使用流程。主要内容包括:1)Git安装指南;2)GitHub账号注册与仓库创建;3)项目代码推送操作(含多账号推送方法);4)SSH密钥配置(一对一和一对多账户场景)。重点讲解了多账号管理时的SSH配置技巧,包括密钥生成、GitHub密钥绑定、config文件修改及连接测试等关键步骤,提供了完整的命令行操作示例,帮助用户实现高效的代码版本控制。

-

elasticsearch的备份以及数据抽取是一个比较常见的需求,es-head这样的浏览器插件虽然也可以实现数据抽取功能,但存在比较严重的条数限制;而dbeaver可以通过jdbc形式连接elasticsearch,但也有一个严重的限制:elasticsearch必须是使用的商业许可证,Elasticsearch的免费版本是不提供JDBC功能的,在查询时会报错current license is non-compliant for [jdbc]需要付费将ElasticSearch升级为白金级别以上。

-

从Gitee迁移至GitHub开源,核心是一次迁移、永久自动同步,无需重复提交与手动维护。本文提供的三种方案覆盖不同使用场景,配合可直接复制的命令与配置清单,可快速实现仅提交一端,双平台自动同步的目标,彻底解决多平台代码托管的繁琐问题。如果在配置过程中遇到权限、同步、冲突等问题,欢迎留言交流;也可分享你的同步实践,共同完善多平台代码托管的最佳方案。

-

Factorization Machines(因子分解机,FM)分类器是一种专门用于处理高维稀疏数据的机器学习模型,尤其适用于特征交互复杂的场景,如推荐系统、广告点击率(CTR)预测等,其核心优势在于能够在线性时间内捕捉特征间的二阶交互作用。

-

本文介绍了Spark中两种重要的Action算子fold和aggregate的使用方法。fold算子通过提供初始值对RDD元素进行分区内和全局聚合,而aggregate则更加灵活,允许分别定义分区内(seqOp)和分区间(combOp)的聚合函数。两种算子都通过Java和Scala代码示例展示了具体实现方式,其中fold使用单一聚合函数,aggregate则支持不同聚合逻辑,适用于更复杂的聚合场景。文章还详细解释了两种算子的函数签名、工作原理和执行过程。

-

本文介绍了一个基于Python和Flask的电影数据可视化与智能分析平台。该系统整合了Echarts可视化工具、线性回归预测算法和协同过滤推荐算法,通过爬虫技术采集猫眼电影数据。主要功能包括:电影数据大屏展示多维度图表分析;数据中心支持数据收藏;数据分析可视化呈现导演作品排行;票房预测模块基于线性回归算法;电影推荐模块采用协同过滤算法;后台管理模块提供数据维护功能;以及用户注册登录系统。该平台为影视从业者和普通用户提供了一体化的电影数据服务,解决了行业数据分散和分析单一的问题。

-

本文深入解析Elasticsearch搜索原理与查询优化技巧。首先剖析倒排索引和中文分词的关键作用,强调IK分词器的重要性。接着详解DSL查询的Query与Filter区别,重点讲解Bool查询的复合逻辑和全文搜索方法。最后提供查询优化实战建议,包括避免深度分页、字段过滤和预计算等。文章指出,掌握底层原理和查询优化思维是构建高效搜索系统的核心,这些技术在AI时代的多模态检索中同样适用。

-

本文采用GD32F103C8T6开发板的标准库GD32F10x_Firmware_Library_V2.6.0,利用标准库的硬件I2C通信,实现了ADS1115的四个通道模拟电压读取。然后直接在标准库里面添加文件夹ads1115_driver,这个文件夹里面包含了开发板PB10和PB11针脚的初始化,程序使用的开发板和ADS1115模块如下,个人买了学习使用。在官网下载了GD32F10x_Firmware_Library_V2.6.0标准库。添加了超时通信,增强了程序的稳定性。处理了通信失败的异常;

-

带认证 python detect_risky_queries.py --host https://es-prod:9200 --username admin --password secret。😅 “一条查询,团灭集群 —— 这不是 bug,是你写的‘核弹’ ,把整个集群拖进了 GC 地狱 :” 哈哈 可惜场景不对;建议没事多去岛上转转。1、全局熔断:老朋友防君子了,这里只是取消查询,在timeout之前 内存恐怖早就炸了。日志狂刷存在感,重启大法也无用:新请求进来,立刻又卡死:资源耗尽型血崩。

-

摘要:本文介绍了Excel导出工具的内存优化策略,针对传统方式一次性加载数据导致的内存过高、GC压力大等问题,提出分批处理、流式写入和缓冲区管理等优化方法。优化后内存占用显著降低,50万条数据时内存降低98.8%。提供了多种使用场景的最佳实践,包括小数据量直接导出、大数据量分批处理等,并强调批次选择、数据库查询优化和内存监控的重要性。注意事项包括输出流管理、线程安全和模板文件处理等。

-

单节点kafka broker,面临很多生产者和访问者的时候,大量的请求和访问大概率会因为吞吐量过大。产生io热点问题,结果就是:这个单一节点成为整个分布式系统的性能瓶颈和节点隐患。进而降低分布式系统的可用性和稳定性。如果数据还没有写入到磁盘文件,而导致数据丢失。当前有两种方式,一种是横向拓展、纵向拓展。横向拓展:单点改为集群。多个节点共同承载。降低单点故障带来的故障纵向拓展:增加单节点服务器配置。比如:使用io效率更好的固态硬盘、切换千兆网卡、切换更优秀的Cpu、增大节点内存等等。

-

本文以内容社区和智能推荐为主线,通过三轮面试串联Spring微服务、Kafka消息队列、Redis缓存、AIGC推荐等主流技术,逐步讲解业务场景与技术要点,助力初学者理清大厂面试主线。

-

后端:Spring Boot + MyBatis-Plus + MySQL。大数据:Hadoop + Hive + Sqoop + MapReduce。前端:Vue.js + Element UI + ECharts。多维度分析:销售趋势、茶叶类型、产地、价格等。基于大数据技术栈构建的完整茶叶行业分析平台。茶叶类型:Top10排行榜及占比分析。完整源代码(前端+后端+大数据处理)实现从数据采集到可视化的全链路处理。销售趋势:月度产销变化分析。产地分析:地理分布与对比。价格分析:价格分布与趋势。

-

本文介绍了一个基于Hadoop生态系统的B站短视频数据分析平台,采用四层数据仓库架构(ODS/DWD/DWS/ADS),实现从数据采集到可视化的完整流程。项目使用MapReduce进行数据清洗,Hive构建数据仓库,Sqoop实现数据同步,最终通过Spring Boot和Vue3实现可视化展示。核心功能包括:视频趋势分析、发布者影响力排名、关键词热度统计等,支持中文数字单位转换、多格式日期处理等复杂数据清洗场景。技术栈涵盖Hadoop、Hive、Spring Boot和Vue3等主流大数据与前后端技术。

-

本文介绍了一个基于Python开发的豆瓣电影数据可视化分析系统。该系统采用Flask框架搭建Web应用,结合MySQL数据库存储数据,使用requests爬虫技术从豆瓣抓取电影信息,并通过Echarts工具实现多维度可视化展示。系统包含10个功能模块:制片地区饼图分析、电影数据列表展示、首页导航、评分漏斗图、类型饼图、类型柱状图、导演作品分析、评分-评论散点图、年度数量折线图以及数据采集页面。这些模块支持交互式数据查询,能够直观呈现电影数据的分布特征和趋势变化。项目实现了从数据采集、清洗存储到可视化分析的全

-

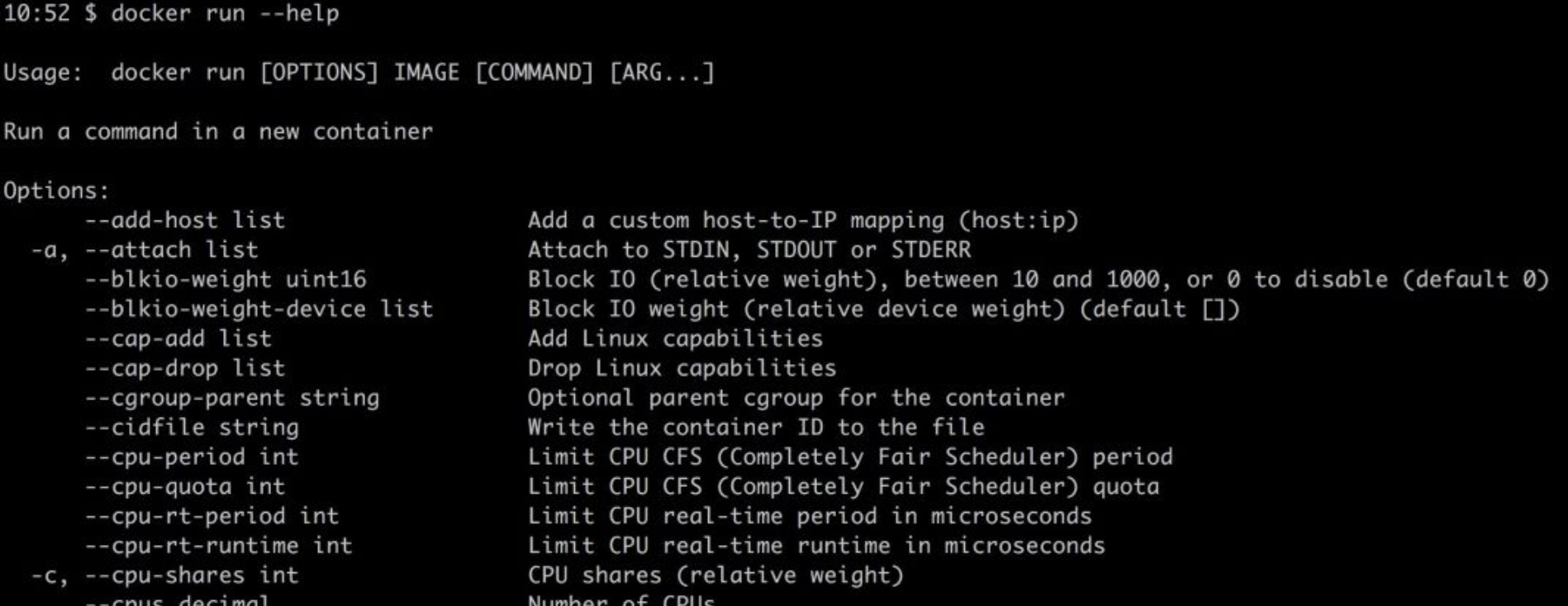

从代码到 Docker、Kubernetes、Istio、Knative……,或许是时候重新思考从代码到云的编程了...

早些时候,开发人员只需编写程序、构建,然后运行。如今,开发人员还需要考虑各种运行方式,作为可执行文件在机器上运行(很有可能是虚拟机),还是打包到容器中;将容器部署到Kubernetes中,还是部署到serverless的环境中或服务网格中。然而,这些部署方式并不是开发人员编程经验的一部分。开发人员必须以某种方式编写代码才能在特定的执行环境中正常工作,因此编程时不考虑这些问题是不行的。

-

Docker容器已经从一种锦上添花的技术转变成了部署环境的必需品。有时,作为开发人员,我们需要花费大量时间调试或研究Docker工具来帮助我们提高生产力。每一次新技术浪潮来临之际,我们都需要花费大量时间学习。

-

最近,我构建了一个本地开发环境,该环境使用 Docker 进行一些关键的集成测试。 在我要完成这项工作时,我意识到在开始这项工作之前,我没有考虑到这么做的一些意义深远影响,如:

-

Docker 概念很难理解?一文搞定 Docker 端口绑定

作为初级开发人员的你,是不是参加过这样的面试,在面试中面试官希望你准确地回答Docker的工作原理?现今的面试官们希望应聘者能够深入了解8项、10项、甚至更多的技术。其实这有点疯狂。在大学或其他学校里,他们很可能根本不会教你任何关于Docker的知识。然而,如果你真的能够深入了解Docker,那么你就可以从一大群应聘者中脱颖而出。

-

6 个步骤,教你在Ubuntu虚拟机环境下,用Docker自带的DNS配置Hadoop | 附代码

最近,作者整理了一套Hadoop搭建方案。最后的镜像大小1.4G多,使用docker子网,容器重新启动不需要重新配置/etc/hosts文件。 配置过程中参考了如下博客,有些细节问题这些博客里面解释的更加详细。

-

自从Docker在2013年初上线以来,就与程序员及系统管理员之间产生了一种爱恨交加的奇妙关系。虽然与我交谈过的一些经验丰富的的开发人员都非常不喜欢容器化(稍后会详细介绍),但是为什么许多大公司,包括eBay、Twitter、Spotify和Lyft在内,都在他们的生产环境中采用了Docker呢?

-

Docker 上手很容易,但如果将其应用于生产环境,则需要对它有更深入的理解。只有这样,才能确保应用符合我们的预期,或在遇到问题时可及时解决。所以,要想真正掌握 Docker 的核心知识,只靠网络上零散的信息往往是不够的,必须系统性地学习。

-

Docker 上手很容易,但如果将其应用于生产环境,则需要对它有更深入的理解。只有这样,才能确保应用符合我们的预期,或在遇到问题时可及时解决。所以,要想真正掌握 Docker 的核心知识,只靠网络上零散的信息往往是不够的,必须系统性地学习。