- 相关博文

- 最新资讯

-

本文结合 19 城实战,详解 Java 大数据在智能停车全场景的应用。含寒地设备优化、应急共享机制等技术方案,实现寻位时间缩 78%,车位利用率提 42%,附可复用代码与民生案例。

-

本文结合 15 家医院 182 台手术,详解 Java 大数据在远程手术机器人数据记录与分析中的应用。通过边缘缓存、跨院协议统一、基层白话分析,实现数据丢失率 0.002%,跨院协作成功率 92%,附实战代码与基层案例。

-

LeetCode 300+(重点:DFS/BFS/DP):如何实现机房故障自动切换,数据同步延迟<500ms?:如何保证MySQL与Redis数据同步?:如何设计支持瞬时高并发的秒杀系统?(Kafka/RocketMQ削峰)(Nginx/Apache动态路由)(适合高并发,但存在时钟回拨问题):跨服务下单如何保证数据一致性?(先删缓存→更新DB→再删缓存):如何实现鉴权、限流、日志聚合?定时对账(AWS Lambda)(DB号段缓冲,适合金融场景)(Sidecar代理流量控制):2N(N=CPU核心数)

-

RabbitMQ 就像一只聪明又可靠的快递兔,不仅知道快递送哪,还能根据地址、内容、类别分门别类、精准投递,堪称消息中间件界的“顺丰”!面试官咳了一声,轻轻扶了扶眼镜,略带敬意地说:“小兄弟,咱们的高级研发岗你来定吧。我笑笑,推门而出,风轻云淡。作者:奇哥标签:#RabbitMQ #消息中间件 #面试吊打。

-

Git 是一个分布式版本控制系统,用于管理和跟踪代码或文件的变更。是软件团队进行代码开发管理的必要工具。GitHub、GitLab 是一个基于 Web 的 Git 仓库,由于 GitHub 的私有仓库是收费的,而 GitLab 是开源的,所以小型团队一般选择自己部署一个 GitLab。为了更好的团队使用,这里梳理下创建用户规范,分支开发规范,提交日志规范,仅适用于小型团队。

-

Java和大数据程序员技术移民指南:选择目标国家(如加拿大、澳大利亚、美国等),提升语言能力(雅思/托福),完成学历认证,积累2-3年工作经验。重点优化技术移民评分(年龄、语言、学历、经验),考取AWS/Google等技术认证,参与开源项目。热门国家对IT人才需求旺盛,需准备护照、成绩单、工作证明等材料。建议分阶段规划,咨询专业中介,关注最新移民政策。技术背景是核心优势,合理规划可实现移民目标。(149字)

-

消息顺序性是确保业务逻辑正确性的关键。当用户连续修改用户名时,若消费顺序错误会导致最终结果不符预期。RabbitMQ在单生产者单消费者时可保证顺序性,但多生产者、多消费者、ACK丢失、路由不同队列或进入死信队列等情况会破坏顺序性。解决方法包括:使用单队列单消费者、分区消费、手动确认ACK,或在消息中添加ID通过业务逻辑控制顺序。这些措施能有效维护消息处理的正确顺序。

-

Elasticsearch集群核心机制解析:分布式架构由节点(Master、数据、协调、Ingest)、分片(主/副本)和集群状态构成,实现水平扩展与高可用。文档写入采用哈希路由和副本同步,搜索请求并行分片查询。保障机制包括心跳检测、分片恢复和防脑裂选举。优化策略含水平扩展、热冷数据分离,生产部署建议专用角色节点分离。故障排查工具包括集群健康检查、任务阻塞定位等。Elasticsearch通过分片、节点、Master和协调层的协同,实现PB级数据的亚秒检索。

-

消息积压是指生产者发送消息速度超过消费者处理能力,导致消息堆积在队列中。常见原因包括:生产者过快、消费逻辑复杂、资源不足、网络问题及服务器性能瓶颈。解决方法:优化消费代码逻辑、设置prefetch参数限制队列容量、异常消息转死信队列;控制生产速率(动态调速或限流);升级服务器配置。通过提升消费效率与合理调控生产速率,可以有效解决消息积压问题。

-

Elasticsearch集群中出现20个节点平分投票(10对10)时,会因未达到法定票数(11票)而陷入脑裂风险,导致主节点缺失、数据不一致和服务中断。主要原因是网络分区或配置不当。解决方案包括:紧急隔离较小节点分区并重启较大分区;长期预防需配置奇数个专用Master节点(如3个)并正确设置法定人数。ES 7.x+版本采用Raft算法可自动处理选举。最佳实践建议物理隔离Master节点并设置监控告警。核心原则是确保可用节点数超过半数,否则系统会停止服务以确保数据一致性。

-

- Kafka 为什么要引入 topic?- Kafka 为什么要引入分区?只有 topic 行不行?- Kafka 为什么要强调把 topic 的分区分散在不同的 broker 上?- Kafka 为什么要引入消费者组概念?只有消费者行不行?

-

下文将简述springboot整合dubbo+zookeeper实现api+provider+consumer模式,Api用于定于interface,provider和consumer依赖Api,provider实现api接口,consumer调用provider。对比api模块增加了qos-enable和qos-port两个属性,QoS是Dubbo提供的运维和管理功能,表示开启;当dubbo-api、dubbo-provider和dubbo-consumer都启动完成后,使用消费者接口访问。

-

安装gitlab并启动,使用以下命令进行启动:安装结果如下:通过本地浏览器打开http://localhost:8080,进入页面注册并登陆:增加管理员权限。

-

看到星云ERP两个比较实用的功能,编号规则和打印模板,如下图所示,(其他环境自行安装,这里不再赘述)于是本地跑起来学习学习。

-

RabbitMQ 使用方法,使用场景,注意事项。

-

Flink 自定义函数(UDF)扩展 Table API/SQL 能力,支持标量函数、表值函数、聚合函数和表值聚合函数四种类型,分别用于值转换、数据拆分、聚合计算和分组统计等场景。实现要点包括:继承对应基类(如 ScalarFunction)、实现核心逻辑方法(eval/accumulate)、注册函数并调用。关键技巧涉及类型注解(@DataTypeHint)、参数命名(@ArgumentHint)和确定性声明。UDF 通过 open/close 管理生命周期,支持异步和批量处理优化。

-

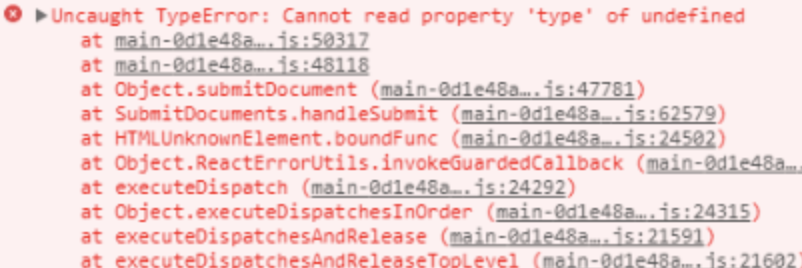

看完这一篇,你就对 Spring Security 略窥门径了

开发Web应用,对页面的安全控制通常是必须的。比如:对于没有访问权限的用户需要转到登录表单页面。要实现访问控制的方法多种多样,可以通过Aop、拦截器实现,也可以通过框架实现,例如:Apache Shiro、Spring Security。我们这里要讲的Spring Security 就是一个Spring生态中关于安全方面的框架。它能够为基于Spring的企业应用系统提供声明式的安全访问控制解决方案。

-

为什么要在油气行业中应用 IoT?这 8 个应用场景告诉你 IoT 在油气行业中可以做什么...

如今,物联网已经进入了各行各业:汽车、农业、绿色能源。物联网还将征服的领域之一是石油和天然气领域。在这些特殊的行业环境中,公司雇佣专业人员来预测机器何时需要维护和保养。通过物联网监控,以确保员工在工作环境中的安全,并改善生产。 麦肯锡 (McKinsey Global Institute)研究表明,到2025年,物联网有可能吸引$11.1T 的资金。

-

ES2020 是 ECMAScript 对应 2020 年的版本。这个版本不像 ES6 (ES2015)那样包含大量新特性。但也添加了许多有趣且有用的特性。本文的代码地址:https://github.com/ljianshu/Blog 本文以简单的代码示例来介绍 ES2020新特性。这样,你可以很快理解这些新功能,而不需要多么复杂的解释。

-

在本文中,我们将开始开发自己的Kubernetes控制器。 技术栈可以是Python、NodeJS或Ruby。因为这个博客被命名为为“ Java极客”,因此选择Java是很正常的。 作为一个用例,我们将实现sidecar模式:每当一个pod被调度时,sidecar pod也会随之被调度。如果将前者删除,则后者也必须删除。

-

其实“数据湖”的概念由来已久,如果追溯时间大概可以到2011年。如今我们经常提及的数据湖其实可以被认为是一个集中式的安全存储库,用户可以任何规模存储、管理、发现并共享所有结构化和非结构化数据,过程中无需预定义架构。

-

医疗保健、零售、金融、制造业……一文带你看懂大数据对工业领域的影响!...

随着大数据技术的兴起,工业领域在很大程度上发生了变化。智能手机和其他通讯方式的使用迅速增加,使得每天都能收集大量数据。以下是大数据对工业领域的影响。

-

2020年已经到来,它的到来带来了信息和技术(IT)领域的诸多创新和变革,特别是对DevOps技术的创新和变革。美国领先的调查机构Grand View Research的专家进行的一项研究宣称,预计到2025年,DevOps的市场价值将达到128.5亿美元。

-

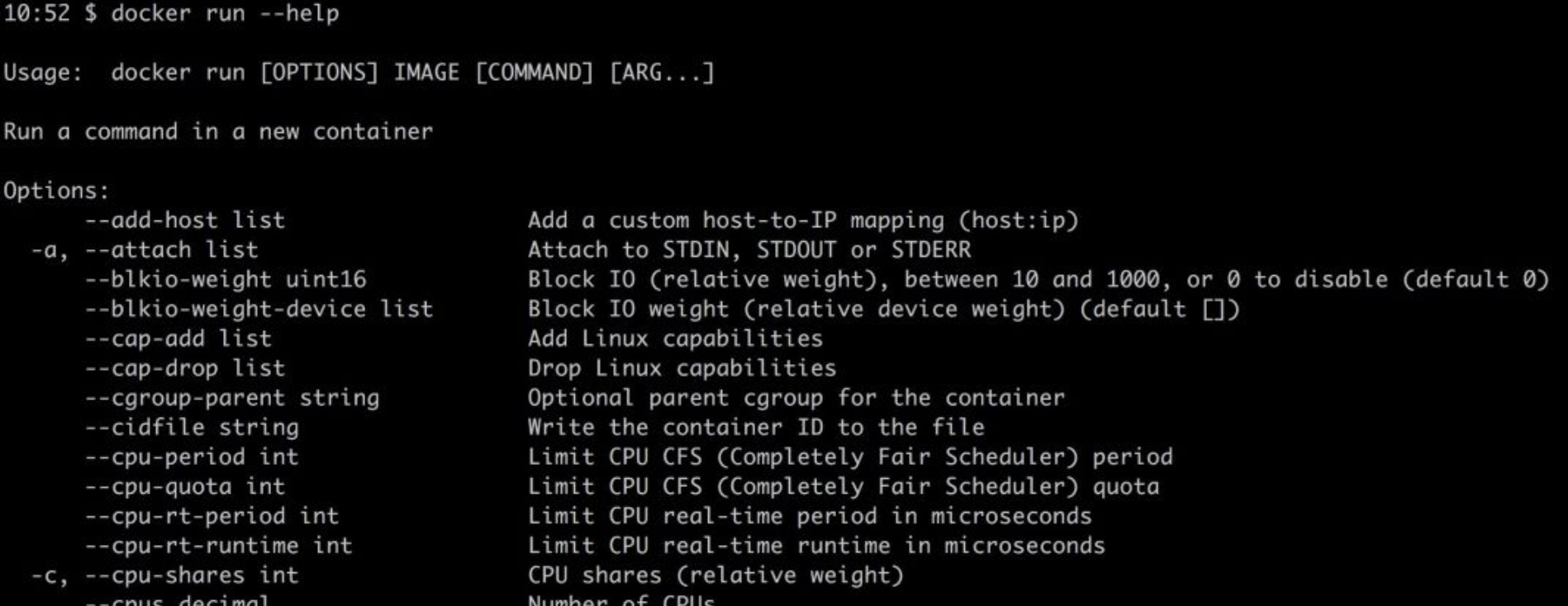

Docker容器已经从一种锦上添花的技术转变成了部署环境的必需品。有时,作为开发人员,我们需要花费大量时间调试或研究Docker工具来帮助我们提高生产力。每一次新技术浪潮来临之际,我们都需要花费大量时间学习。

-

SQL是用于数据分析和数据处理的最重要的编程语言之一,因此SQL问题始终是与数据科学相关工作(例如数据分析师、数据科学家和数据工程师)面试过程中的一部分。 SQL面试旨在评估应聘者的技术和解决问题的能力。因此,至关重要的是,不仅要根据样本数据编写正确的查询语句,而且还要像对待现实数据集一样考虑各种情况和极端情况。

-

近日,阿里云对外宣布其容器服务调度GPU云服务器启动加速计算,最快只需60秒即可完成新冠病毒的核酸对比工作;同时将向医疗科研机构、疾控中心等一线病毒研究机构免费开放基因计算服务,技术可大幅提升宏基因组测序、疫苗研发相关的处理效率。基于此,晶少专程采访了阿里云基因计算服务AGS负责人、高级技术专家李鹏,集中呈现针对GPU和容器技术大幅提升核酸比对速度的有关细节以及关于阿里云基因计算服务(AGS)的诸多信息。

-

最近,我构建了一个本地开发环境,该环境使用 Docker 进行一些关键的集成测试。 在我要完成这项工作时,我意识到在开始这项工作之前,我没有考虑到这么做的一些意义深远影响,如:

-

数据库连接池和线程池等池技术存在的意义都是为了解决资源的重复利用问题。在计算机里,创建一个新的资源往往开销是非常大的。而池技术可以统一分配,管理某一类资源,它允许我们的程序可以重复的使用这个资源,只有在极端情况下(比如连接池满)才会创建新的资源。

-

从提取层、处理层、基础结构入手,带你了解Spark和Kafka!

电子商务市场中典型的一天是这样的:每分钟发生1万个事件流,并且要选择合适的工具对其进行处理。

-

随着业务的发展,MySQL数据库中的表会越来越多,表中的数据量也会越来越大,相应地,数据操作的开销也会越来越大;另外,无论怎样升级硬件资源,单台服务器的资源(CPU、磁盘、内存、网络IO、事务数、连接数)总是有限的,最终数据库所能承载的数据量、数据处理能力都将遭遇瓶颈。

-

王坚博士曾经做过这样一个非常形象的比喻,他将做 App 比作是在别人的花园里弄盆栽,「种点花草是没有问题的」,不过「别人叫你的产品下架你就得下架,这是有问题的」,现在在 GitHub 上,众多的开发者显然遭遇了这样的问题。