- 相关博文

- 最新资讯

-

艾莉丝已经把【Git版本控制器】这个板块内容都整理成博客啦,所以Linux主线专栏这里我们就寥寥几笔,直接带过。详解Git原理与使用艾莉丝把此专栏的链接都挂在下面了,大家可以根据实际需要乘坐【传送门】哦!【Git:基本操作】深度解析Git:从初始Git到熟悉基本操作【Git:分支管理】Git分支管理完全指南:从创建、合并到冲突解决【Git:深度解析Git远程操作和标签管理】从克隆到推送:Git远程操作与标签管理完全指南【Git:多人协作】Git多人协作实战:从同分支到多分支工作流。

-

本文探讨了时序数据快速增长背景下企业选型时序数据库的关键考量。重点介绍了Apache IoTDB这一专为工业物联网设计的开源时序数据库,其特点包括:1)列式存储引擎TsFile实现高效压缩(10-20倍);2)树状数据模型匹配工业设备层级;3)高性能读写(1000万点/秒写入)。文章通过性能对比和实际应用案例(如宝武钢铁、长安汽车等)展示了IoTDB在工业制造、能源电力等领域的优势,包括高可用架构、端边云协同等特性。最后针对不同行业场景提供了选型建议,指出IoTDB在性能、生态和扩展性方面的综合优势。

-

大数据时序数据库选型核心在于“技术适配场景”。Apache IoTDB通过TsFile时序格式、分层微内核架构、向量化查询引擎等核心技术创新,解决了高吞吐写入、高效存储、实时分析等关键痛点。其在工业、电力等领域的规模化落地,验证了其技术架构的稳定性与扩展性,是国产化时序数据库在大数据场景下的优选方案。

-

本文系统介绍了Git分支管理的核心概念与实践技巧。主要内容包括:1)分支的本质与价值,解析时间线分叉、HEAD指针等关键概念;2)基础操作指南,涵盖创建、切换、合并、删除分支的具体命令;3)合并冲突解决方案,通过案例演示如何手动编辑冲突文件;4)企业级分支策略,对比GitFlow模型与简化方案的适用场景;5)实战Bug分支管理,讲解git stash暂存与恢复的技巧;6)常见问题排查,提供切换分支丢失修改等典型问题的应对方案。

-

RabbitMQ消息可靠性保障方案 RabbitMQ通过两种机制确保消息可靠传输: 发送方确认机制: Confirm模式:确认消息是否到达Exchange Return模式:处理无法路由到队列的消息 通过设置ConfirmCallback和ReturnsCallback实现回调处理 消费者确认机制: 三种确认模式:NONE(自动)、MANUAL(手动)、AUTO(异常时重试) 可配置重试参数:间隔时间、最大重试次数 手动模式下需显式调用basicAck/basicNack 完整可靠性方案包括: 生产者到Ex

-

【代码】2501_MU_SE_FZU Extreme Programming_Upgraded contacts。

-

当 AI 大模型推理面临异构算力调度失衡、显存瓶颈制约,当大数据处理深陷吞吐不足、资源浪费的困境,传统算力管理方案早已难以适配智能时代的高效需求。openFuyao 跳出 “单点优化” 的局限,以 “AI + 大数据场景专属加速引擎” 为核心定位,通过三大维度的深度技术革新,直接击穿场景核心痛点,让算力利用效率实现量级跃升,成为真正意义上 “为加速而生” 的算力系统重构者。

-

领码SPARK融合平台:企业数字化转型的智能底座 领码SPARK融合平台通过"连、搭、慧"三位一体策略,为企业提供iPaaS与aPaaS深度融合的数字化解决方案。其iPaaS引擎支持多协议连接,实现企业系统高效集成;aPaaS低代码能力支持全栈可视化开发,加速应用构建;AI深度赋能开发、运维与业务决策,形成"连接-构建-优化"的闭环。该平台采用双引擎架构,以元数据驱动为核心,已在金融、零售、制造等行业落地,帮助企业打破数据孤岛,实现业务敏捷创新与持续进化。

-

摘要:本文设计了一个基于大数据、物联网和云计算技术的应急救援云平台。平台采用四层架构(基础设施层、数据层、支撑层、应用层),结合B/S、C/S和分布式集群服务模式,运用Hadoop、Spark等技术实现数据实时与离线处理。平台功能包括监测预警、应急通信、智能指挥和灾后评估,为应急管理提供科学决策支持,提升突发事件应对能力。研究成果为广西高校科研项目阶段性成果。

-

本文摘要:文章详细介绍了Git远程仓库推送的两种方式——HTTPS和SSH。HTTPS方式包括创建本地仓库、设置用户信息、建立远程连接及推送代码的完整流程;SSH方式则重点讲解了账户公钥和仓库公钥的生成与配置方法,包括密钥生成、Gitee公钥配置、连接验证等关键步骤。两种方式都涵盖了从本地仓库初始化到远程推送的全过程,并特别说明了强制同步、分支关联等实用技巧,为开发者提供了全面的Git远程操作指南。

-

本文介绍了在ElasticSearch集群出现主副本分片同时unassigned时的数据恢复方案。当系统文件句柄耗尽导致分片不可分配时,虽然磁盘数据仍存在,但ES会因安全验证失败而拒绝自动恢复。文章详细解析了两种底层恢复机制:allocate_stale_primary(从磁盘恢复可能回滚数据)和allocate_empty_primary(重建空分片),并给出了工程化的恢复流程,包括系统修复、分片检查、逐分片恢复策略表等关键步骤。最后强调恢复后的数据校验和集群加固措施,指出掌握磁盘级恢复技术对保障搜索系统

-

本文介绍了ELK(Elasticsearch、Logstash、Kibana、Metricbeat)日志系统解决方案及其在企业IT环境中的应用。ELK结合Beats组件可实现多源数据的统一采集、处理与可视化,帮助提升系统监控和故障响应能力。文章详细解析了各核心组件功能:Elasticsearch用于存储和查询日志数据,Logstash负责日志处理,Kibana提供可视化界面,Beats实现轻量级数据采集。此外还介绍了Kafka作为可选中间件的作用。最后简要说明了该系统的部署架构方案。

-

Zookeeper笔记

-

你是否曾经因为忘记压缩包密码而焦急万分?重要的工作文档、珍贵的照片资料被锁在加密压缩包里无法打开?别担心,ArchivePasswordTestTool正是为你量身定制的解决方案!## 🔐 工具核心亮点**ArchivePasswordTestTool**是一款基于7zip引擎的开源密码测试工具,专门用于自动化测试加密压缩包的密码。它让密码找回过程变得前所未有的简单高效。**三大核心

-

RabbitMQ 是基于实现的开源消息中间件,由 Erlang 语言开发,核心优势是高可用、可扩展、支持多种消息模式,广泛用于系统解耦、异步通信、流量削峰等场景。

-

在生产端主要有两个线程:main和sender,两者通过共享内存RecordAccumulator通信。

-

本研究以Hadoop分布式系统为核心,系统阐述了大数据集群故障诊断与修复的全流程方法论。结合第一性原理与工程实践,从概念基础、理论框架到架构设计、实现机制,逐层拆解Hadoop集群的故障类型(节点宕机、数据损坏、资源争用等),并提供可操作的诊断工具链(如hdfs fsck、Prometheus监控)与修复策略(如Quorum Journal Manager解决脑裂、Erasure Coding优化存储容错)。同时,通过多层次解释框架(专家→中级→入门)与可视化工具。

-

ES|QL(Elasticsearch Query Language)是一种专为 Elasticsearch设计的、管道式的数据查询语言。它于2023年正式推出,Elasticsearch 8.11+ 引入的一种新的查询语言,类似于传统的 SQL但更专注于流式数据处理,旨在提供比传统 Query DSL 更直观、更强大且更易于学习的数据探索和转换能力。核心设计哲学1. 管道式处理:数据像在流水线上一样,依次通过一系列命令(称为“操作符”)进行处理,每个操作符接收上一个操作符的输出作为输入。2. 声明式。

-

看完这一篇,你就对 Spring Security 略窥门径了

开发Web应用,对页面的安全控制通常是必须的。比如:对于没有访问权限的用户需要转到登录表单页面。要实现访问控制的方法多种多样,可以通过Aop、拦截器实现,也可以通过框架实现,例如:Apache Shiro、Spring Security。我们这里要讲的Spring Security 就是一个Spring生态中关于安全方面的框架。它能够为基于Spring的企业应用系统提供声明式的安全访问控制解决方案。

-

为什么要在油气行业中应用 IoT?这 8 个应用场景告诉你 IoT 在油气行业中可以做什么...

如今,物联网已经进入了各行各业:汽车、农业、绿色能源。物联网还将征服的领域之一是石油和天然气领域。在这些特殊的行业环境中,公司雇佣专业人员来预测机器何时需要维护和保养。通过物联网监控,以确保员工在工作环境中的安全,并改善生产。 麦肯锡 (McKinsey Global Institute)研究表明,到2025年,物联网有可能吸引$11.1T 的资金。

-

ES2020 是 ECMAScript 对应 2020 年的版本。这个版本不像 ES6 (ES2015)那样包含大量新特性。但也添加了许多有趣且有用的特性。本文的代码地址:https://github.com/ljianshu/Blog 本文以简单的代码示例来介绍 ES2020新特性。这样,你可以很快理解这些新功能,而不需要多么复杂的解释。

-

在本文中,我们将开始开发自己的Kubernetes控制器。 技术栈可以是Python、NodeJS或Ruby。因为这个博客被命名为为“ Java极客”,因此选择Java是很正常的。 作为一个用例,我们将实现sidecar模式:每当一个pod被调度时,sidecar pod也会随之被调度。如果将前者删除,则后者也必须删除。

-

其实“数据湖”的概念由来已久,如果追溯时间大概可以到2011年。如今我们经常提及的数据湖其实可以被认为是一个集中式的安全存储库,用户可以任何规模存储、管理、发现并共享所有结构化和非结构化数据,过程中无需预定义架构。

-

医疗保健、零售、金融、制造业……一文带你看懂大数据对工业领域的影响!...

随着大数据技术的兴起,工业领域在很大程度上发生了变化。智能手机和其他通讯方式的使用迅速增加,使得每天都能收集大量数据。以下是大数据对工业领域的影响。

-

2020年已经到来,它的到来带来了信息和技术(IT)领域的诸多创新和变革,特别是对DevOps技术的创新和变革。美国领先的调查机构Grand View Research的专家进行的一项研究宣称,预计到2025年,DevOps的市场价值将达到128.5亿美元。

-

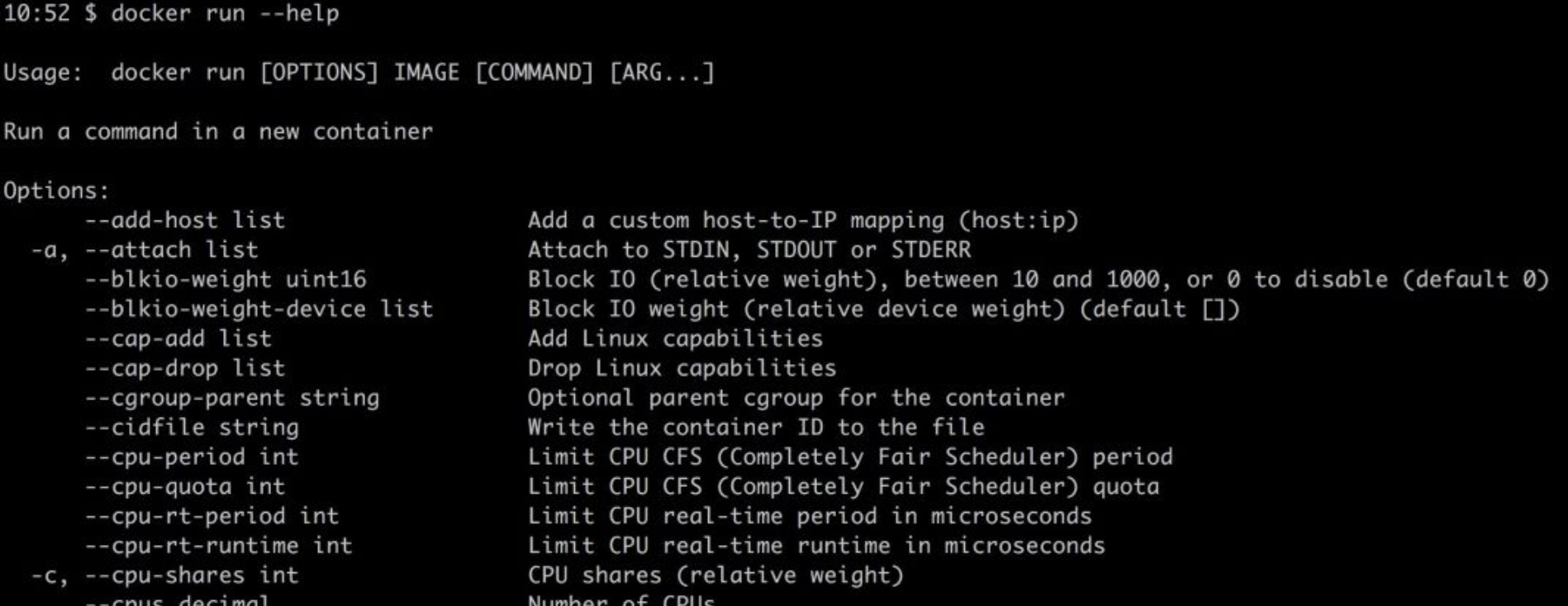

Docker容器已经从一种锦上添花的技术转变成了部署环境的必需品。有时,作为开发人员,我们需要花费大量时间调试或研究Docker工具来帮助我们提高生产力。每一次新技术浪潮来临之际,我们都需要花费大量时间学习。

-

SQL是用于数据分析和数据处理的最重要的编程语言之一,因此SQL问题始终是与数据科学相关工作(例如数据分析师、数据科学家和数据工程师)面试过程中的一部分。 SQL面试旨在评估应聘者的技术和解决问题的能力。因此,至关重要的是,不仅要根据样本数据编写正确的查询语句,而且还要像对待现实数据集一样考虑各种情况和极端情况。

-

近日,阿里云对外宣布其容器服务调度GPU云服务器启动加速计算,最快只需60秒即可完成新冠病毒的核酸对比工作;同时将向医疗科研机构、疾控中心等一线病毒研究机构免费开放基因计算服务,技术可大幅提升宏基因组测序、疫苗研发相关的处理效率。基于此,晶少专程采访了阿里云基因计算服务AGS负责人、高级技术专家李鹏,集中呈现针对GPU和容器技术大幅提升核酸比对速度的有关细节以及关于阿里云基因计算服务(AGS)的诸多信息。

-

最近,我构建了一个本地开发环境,该环境使用 Docker 进行一些关键的集成测试。 在我要完成这项工作时,我意识到在开始这项工作之前,我没有考虑到这么做的一些意义深远影响,如:

-

数据库连接池和线程池等池技术存在的意义都是为了解决资源的重复利用问题。在计算机里,创建一个新的资源往往开销是非常大的。而池技术可以统一分配,管理某一类资源,它允许我们的程序可以重复的使用这个资源,只有在极端情况下(比如连接池满)才会创建新的资源。

-

从提取层、处理层、基础结构入手,带你了解Spark和Kafka!

电子商务市场中典型的一天是这样的:每分钟发生1万个事件流,并且要选择合适的工具对其进行处理。

-

随着业务的发展,MySQL数据库中的表会越来越多,表中的数据量也会越来越大,相应地,数据操作的开销也会越来越大;另外,无论怎样升级硬件资源,单台服务器的资源(CPU、磁盘、内存、网络IO、事务数、连接数)总是有限的,最终数据库所能承载的数据量、数据处理能力都将遭遇瓶颈。

-

王坚博士曾经做过这样一个非常形象的比喻,他将做 App 比作是在别人的花园里弄盆栽,「种点花草是没有问题的」,不过「别人叫你的产品下架你就得下架,这是有问题的」,现在在 GitHub 上,众多的开发者显然遭遇了这样的问题。