- 相关博文

- 最新资讯

-

i 智慧 | 回首30年存储演进之路 再看新数据时代阿里云存储如何革故鼎新?

人类以日新月异的速度刷新着科技的成果,其中存储的发展历史尤其悠久,堪称万年进化史。自文明诞生以来,我们就一直在寻求能够更有效存储信息的方式,从4万年前的洞穴壁画、6000年前泥板上的楔形文字,到今天普及的SSD/闪存,再到对量子存储、DNA存储技术的探索,脚步从未停止。据IDC预测,2025年全球数据将有175 ZettaBytes的总量。如此惊人而又庞大的数据量,为存储市场带来机遇的同时,也带来了不小的挑战。

-

雪花算法(snowflake) :分布式环境,生成全局唯一的订单号

snowflake是Twitter开源的分布式ID生成算法,结果是一个long型的ID。 这种方案大致来说是一种以划分命名空间(UUID也算,由于比较常见,所以单独分析)来生成ID的一种算法,这种方案把64-bit分别划分成多段,分开来标示机器、时间等。 其核心思想是:使用41bit作为毫秒数,10bit作为机器的ID(5个bit是数据中心,5个bit的机器ID),12bit作为毫秒内的流水号,最后还有一个符号位,永远是0。

-

据晶少了解,国庆假期后的首个工作日,AWS就在中国区域放出了一款“重量级”容器服务,名为 AWS Fargate,光环新网运营的 AWS 中国(北京)区域和西云数据运营的 AWS 中国(宁夏)区域均提供该项服务。据悉这是一款可以适用于 Amazon ECS的计算引擎,主要帮助企业在生产过程中运行容器、却无需部署或者管理服务器,换句话说就是专注设计和构建应用程序,而不用挂心太多基础设施的“那些事儿”。

-

-

桌面智能分析产品+“智同211”计划,永洪科技打造数据价值生态圈!

企业如何更好地去挖掘数据价值,赋能产品创新和业务的迭代?数据时代,企业如何更好的利用数据进行数字化转型?在永洪科技主办的“智同道合,数创未来”第一届数据分析技术与应用高峰论坛上,或许能找到你想知道的。

-

排序算法这么多,这里先将排序算法做个简单分类: 一、可以根据待排序的数据量规模分类: 内部排序:在排序过程中,待排序的数据能够被全部加载进内存中 外部排序:待排序的数据太大,不能全部同时放入内存,排序过程中需要内存与外部存储交换数据

-

蚂蚁金服自研数据库OceanBase登顶TPC-C榜单的消息振奋人心,同时引起国内技术圈的广泛讨论,第一个云上跑出来的数据库分数含金量如何?其他数据库有没有可能更强?

-

Teradata上新Vantage Customer Experience和Vantage Analyst,都是啥?

近日Teradata宣布推出Vantage CX(Vantage Customer Experience)解决方案,以此改变世界上创新性的数据驱动型公司的客户体验。

-

-

-

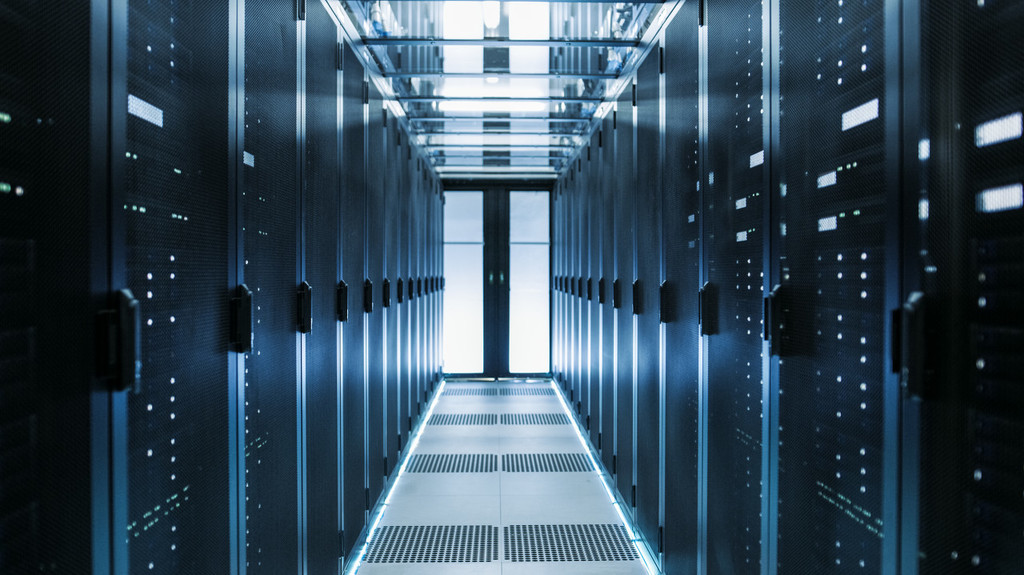

服务器对每个从事IT工作的人来说并不陌生,但是服务器所涉及的各种知识细节,并非大家都十分清楚,为了让大家深入了解服务器的关键知识点,笔者特意抽时间总结了这篇科普文章,旨在帮助读者全面了解服务器。今天内容就从服务器的架构和分类开始。

-

Q:什么是Spark?A:简单理解,Spark是在Hadoop基础上的改进,是UC Berkeley AMP lab所开源的类Hadoop MapReduce的通用的并行计算框架,Spark基于map reduce算法实现的分布式计算,拥有Hadoop MapReduce所具有的优点;但不同于MapReduce的是Job中间输出和结果可以保存在内存中,从而不再需要读写HDFS,因此Spark能更好地适用于数据挖掘与机器学习等需要迭代的map reduce的算法。